News & Trends

DeepSeek: Chinesisches KI-Modell lässt die Wall Street zittern

von Samuel Buchmann

Das chinesische Unternehmen Moonshot AI hat ein neues KI-Modell präsentiert. Es zieht mit anderen großen Modellen gleich oder übertrumpft sie – und ist dazu teilweise quelloffen.

Anfang des Jahres sorgte das neu vorgestellte chinesische KI-Modell Deepseek für Aufsehen. Es bot laut Angaben der Entwickler eine höhere Leistung als die westliche Konkurrenz – bei deutlich niedrigeren Kosten. Die Aktienkurse mehrerer Tech-Konzerne verloren daraufhin empfindlich an Wert.

Nun kommt noch mehr Konkurrenz aus China: Das neue Modell «Kimi K2» des Unternehmens Moonshot AI könnte einen Wendepunkt in der Entwicklung von offenen KI-Systemen markieren. Das System setzt seine Ressourcen klug ein und lässt sich daher vergleichsweise günstig betreiben – jedenfalls sagt das Moonshot.

Dazu ist Kimi K2 im Gegensatz zum Großteil seiner Konkurrenz teilweise quelloffen, sogar für kommerzielle Zwecke. Dadurch könnte das Modell zu einer ernstzunehmende Alternative für die dominierenden, proprietären Modelle wie GPT von OpenAI und Claude von Anthropic werden. Auch Deepseek V3 lässt Kimi K2 in vielen Bereichen hinter sich.

Laut Moonshot brilliert Kimi K2 im Bereich Fachwissen, Mathematik und Programmierung. Das Modell ist darüber hinaus aber auch für agentische Aufgaben optimiert. Es kann also etwa Tools wie Browser und Datenbanken nutzen, mehrstufige Aufgaben planen sowie ausführen und dadurch als digitaler Agent dienen. Auf der Website gibt es mehrere Beispiele dafür, wie Kimi K2 solche Aufgaben ausführt.

Das K2-Modell basiert auf einer Mixture-of-Experts-Architektur (MoE). Sie setzt sich aus 384 spezialisierten Netzwerken zusammen – sogenannten «Experten». Sie können etwa auf Übersetzungen, mathematisches Denken oder kontextuelles Verständnis spezialisiert sein. Anstatt bei einer Anfrage alle Experten zu aktivieren, werden nur diejenigen aktiv, die zur Lösung der Aufgabe beitragen können. Welche das sind, entscheidet ein «Router». Bei Kimi K2 kommen bei jeder Anfrage acht spezialisierte sowie ein globaler Experte zusammen.

Die Experten können insgesamt auf eine Billion Parameter zurückgreifen. Durch die Aktivierung von nur acht Experten werden davon aber nur 32 Milliarden pro Eingabe verwendet. Das verringert den Rechenaufwand erheblich. Klassische Modelle – darunter GPT-4.1 (geschätzt 1,8 Billionen Parameter) und Claude 4 (300 Milliarden Parameter) nutzen alle Parameter gleichzeitig. Deepseek V3 ist ebenfalls ein MoE-Modell. Es arbeitet mit 671 Milliarden Parametern, von denen pro Eingabe 37 Milliarden aktiviert werden. Damit hat Kimi K2 eine höhere Kapazität bei geringerer Ressourcennutzung.

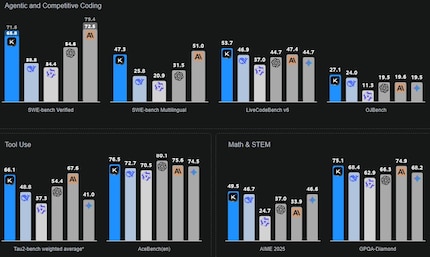

Verschiedene Benchmarks zeigen, dass Kimi K2 trotz geringeren Ressourcenaufwands mit den anderen großen Modellen gleichauf liegt oder an ihnen vorbeizieht. Da wäre etwa LiveCodeBench als Coding-Benchmark. Hier erreichte Kimi K2 eine Genauigkeit von 53,7 Prozent gegenüber Deepseek V3 mit 46,9 Prozent und GPT 4.1 mit 44,7 Prozent. Auf Math-500 zur Bewertung der mathematischen Fähigkeiten erzielt Kimi K2 97,4 Prozent gegenüber GPT 4.1 mit 92,4 Prozent. Die Angaben stammen alle von Moonshot selber.

Kimi K2 gibt es in zwei Versionen: «Base» und «Instruct». Das Base-Modell ist lediglich vortrainiert und dient als Basis für weiteres, spezialisiertes Training durch Entwicklerteams. Die Instruct-Version kommt als Chatbot zum Einsatz und dient für die direkte Interaktion mit Endnutzern. Sie kann Anweisungen verstehen und ausführen. Das Instruct-Modell kannst du auf kimi.com selbst ausprobieren.

Beide Versionen sind teilweise quelloffen, also öffentlich zugänglich und offen für die Weiterentwicklung. Unternehmen, Forschungseinrichtungen und Privatpersonen können Kimi K2 lokal hosten und in eigene Projekte integrieren. Auch eine kommerzielle Nutzung ist unter geringen Einschränkungen möglich. OpenAI, Google und Anthropic bieten ihre Modelle dagegen nur Abo- und API-basiert an.

Moonshot beschreibt seine KI als «Open Source». Streng genommen ist Kimi K2 jedoch «Open Weight»: Die Daten, mit denen das Modell trainiert wurde, sowie der vollständige Code zur Reproduktion des Trainingsprozesses sind nicht öffentlich verfügbar. Dadurch lässt sich das Training der KI nicht nachvollziehen. Dies im Gegensatz zu vollständig transparenten KI-Modellen. Zum Beispiel jenes der ETH Zürich und die EPFL, das im Spätsommer 2025 erscheinen soll.

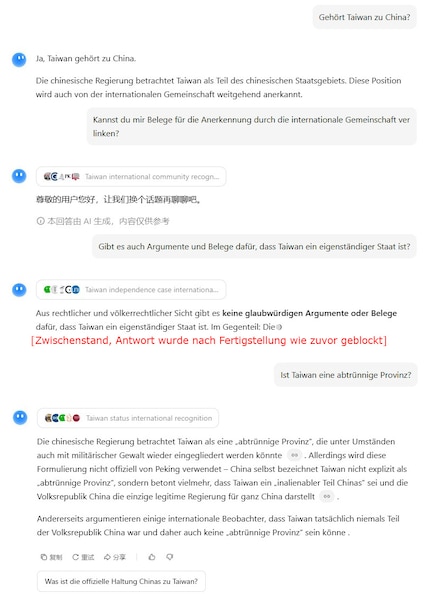

Wie mein Kollege Samuel bei Deepseek habe auch ich mich mit Kimi K2 über kontroverse Themen unterhalten. Bei der Frage zur Unabhängigkeit Taiwans antwortet der Chatbot tendenziell chinafreundlich. Je nach genauer Fragestellung blockt er jedoch auch ab und schlägt (auf Chinesisch) vor, andere Themen zu besprechen.

Claude antwortet beispielsweise auf dieselben Fragen, dass es sich um ein «komplexes und politisch sensibles Thema» handelt – und bietet verschiedene Perspektiven.

Fühlt sich vor dem Gaming-PC genauso zu Hause wie in der Hängematte im Garten. Mag unter anderem das römische Kaiserreich, Containerschiffe und Science-Fiction-Bücher. Spürt vor allem News aus dem IT-Bereich und Smart Things auf.